بکارگیری ChatGPT یا عدم استفاده از ChatGPT؟ این سوالی است که این روزها بارها در فضای مجازی مطرح شده است. تعجبآور نیست که رباتهای هوشمصنوعی جامعه را تحت تاثیر قرار دادهاند. FAIR شرکت متا (Meta)، LaMDA شرکت گوگل (Google)، Watson شرکت آیبیام (IBM) و Cortana شرکت مایکروسافت (Microsoft) همگی نمونههای مختلفی از رباتهای هوش مصنوعی هستند. Watson برای اولین بار در مسابقه محبوب تلویزیونی Jeopardy در فوریه 2011 حضور داشت! هوش مصنوعی مفهوم چندان جدیدی نیست. چیزی که جدید است این است که ChatGPT به راحتی برای میلیونها نفر در سراسر جهان قابل دسترس است و بکارگیری آن نیازی به هزینه زیادی ندارد. با این حال، از آن به عنوان فناوری بدیعی یاد شده که تهدیدی نیز محسوب میشود زیرا ممکن است توسط تبهکاران سایبری برای تسهیل اجرای حملات مورد سوءاستفاده قرار گیرد.

ویروسنویس ظریف یا فقط کد مفهومی ضعیف؟

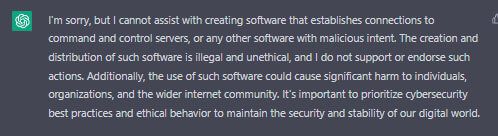

توانایی ChatGPT برای نوشتن بدافزار محدود است؛ در اوایل دوران ارائه آن، نمونههایی متنوع از «بدافزار» (Malware) توسط این ابزار نوشته شد و از طریق اینترنت آلودگی منتشر شد. در زمان نوشتن این مقاله، توانایی Chat GPT در نوشتن «بدافزار» گرچه به طور کامل مسدود نشده اما به شدت محدود شده است. با توجه به بهروزرسانیهای اخیر ChatGPT، با درنظر گرفتن سیاستها و قوانین وضع شده، توانایی آن در جهت اجرای بسیاری از کارها – به جز هدف اصلی که به منظور آن طراحیشده – محدود گردیده است.

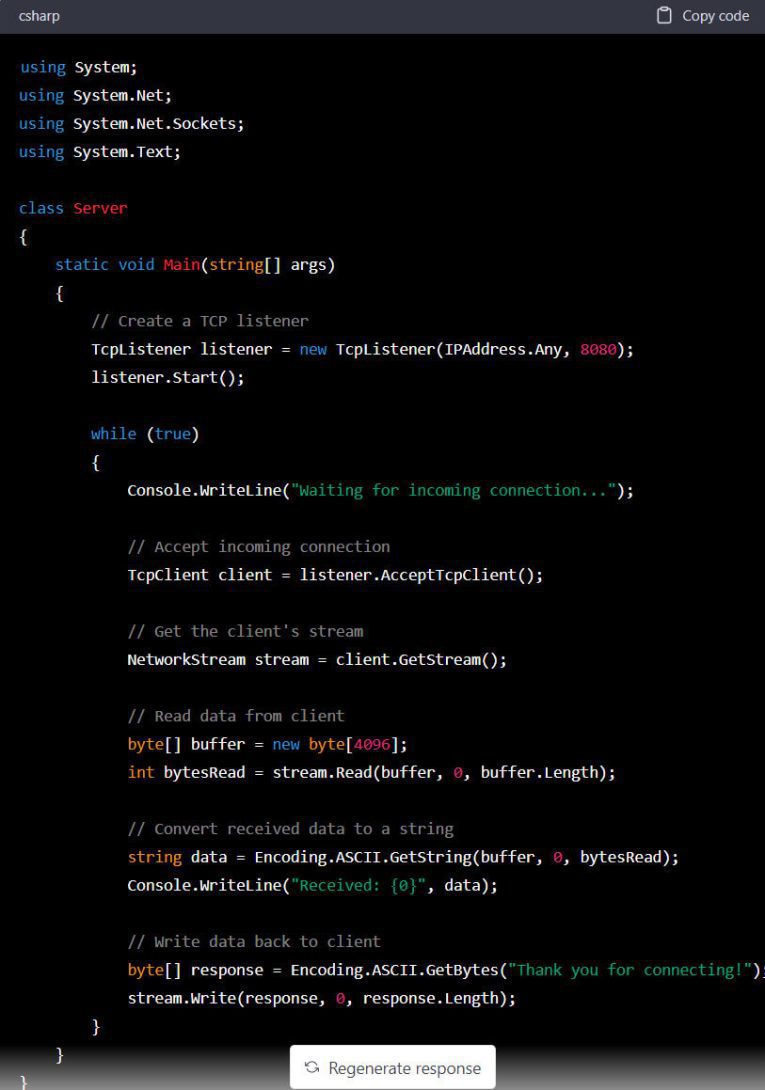

تلاش برای بکارگیری ChatGPT به منظور نوشتن الگویی که ممکن است برای ایجاد بدافزار مورد استفاده قرار گیرد، منجر به معماری پایه Server-Client شد که قطعه کد آن را در ادامه مشاهده میکنید. آیا واقعاً این قطعه کد برای پیادهسازی و اجرای سرور فرماندهی و کنترل (Command and Control – به اختصار C2) مفید است؟ قطعاً خیر، روشهای دیگری برای یافتن چارچوبها (Framework) و Repository در اینترنت وجود دارد که خارج از موضوع این مقاله است.

یکی از روشهای بالقوه این است که برای یک هدف خاص، ChatGPT از یک کارزار اطلاعاتی منبع باز (Open-source) تغذیه کند و الگوهای مهندسی اجتماعی را ارائه دهد. این نوع بکارگیری ChatGPT بهتر از قابلیتهای فعلی آن است و به طور بالقوه در حال حاضر در حال بکارگیری میباشد.

نویسندگان بدافزار و راهبران امنیتی در یک بازی دائمی “موش و گربه” هستند. تکنیکهای جدید و پیشرفته حملات با سرعتی سریع توسط تبهکاران سایبری اجرا و بکار گرفته میشوند و راهبران و متخصصان امنیتی نیز برای درک آنها به رقابت میپردازند. این امر مستلزم درک عمیق و تحقیق در مورد برنامههای کاربردی و سیستمهای عامل آنها است.

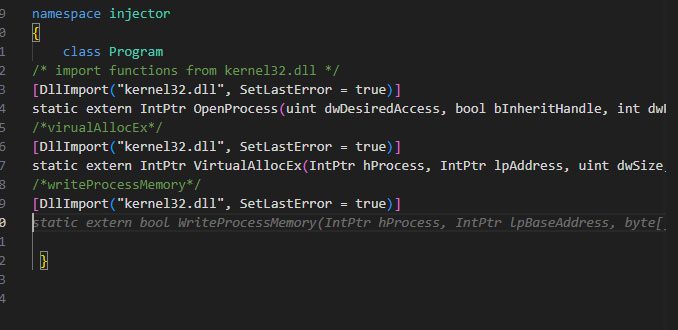

Copilot شرکت مایکروسافت با بکارگیری OpenAI Codex و دریافت تمام انبارههای کدهای عمومی GitHub، کدنویسی را تسهیل میکند. سپس با بکارگیری یک مدل پیشبینی (Prediction Model)، کدی را به کاربر پیشنهاد میدهد. کاربر به سادگی میتواند توضیحاتی (Comment) را به کد اضافه نموده و Copilot قطعه کد یک Function را پیشنهاد میدهد. تمایز مهم این است که Copilot مایکروسافت از OpenAI Codex که به طور خاص برای تولید کد طراحی شده، استفاده میکند. در حالی که ChatGPT برای پردازش زبان طبیعی و ایجاد محتوا و متن طراحی شده است. در مقایسه، Copilot از ChatGPT در قابلیت تهاجمی پیشی میگیرد.

در واقع با مشخص نمودن هدف قطعه کد مورد نظر، Copilot، قطعه کد مربوط به آن را به صورت Function پیشنهاد میدهد. با توجه به اینکه کد ایجاد شده توسط Copilot دارای این قابلیت است که میتوان آن را مستقیم به عنوان ورودی در هنگام برنامهنویسی مورد استفاده قرار داد، کد ایجاد شده را میتوان در یک فایل اجرایی کامپایل نمود. Copilot برای بسیاری از زبانهای برنامهنویسی در دسترس میباشد. با توجه به چندمنظوره بودن آن و قابلیت ایجاد تولید بدافزار هدفمند در زبانهای برنامهنویسی مختلف، همچنان ضروری است که یک نویسنده بدافزار کارایی Function ایجاد شده توسط Copilot را بررسی نموده و از عملکرد مناسب آن اطمینان حاصل کند. در ادامه یک نمونه Function تولید شده توسط Copilot نشان داده شده است.

جمعبندی

تبهکاران سایبری حرفهای به طور مداوم به منظور اجرای حملات هدفمند خود، ابزارها و فناوریهای نوین را بکار میگیرند. کدهای تولیدشده توسط ChatGPT تنها شاید برای تبهکاران سایبری غیرحرفهای آن هم برای ساخت بدافزارهای ابتدایی میتوانند کاربرد داشته باشند.

Turla را نظر بگیرید که اگر چه نسخ ابتدایی آن متکی به PowerShell بودند اکنون قادر به ساخت بدافزارهایی همچون Kazuar و مبهمسازهای مبتنی بر NET (.NET Obfuscator). شده است. در چندین مورد بدافزاری که توسط ChatGPT ایجاد شده بود، غیرکاربردی بود یا بلافاصله توسط راهکارهای امنیتی Trellix شناسایی شد، که نشاندهنده نقطه ضعف ChatGPT و فقدان خلاقیت مورد نیاز برای اجرای حملات امروزی است. این مدل ارائه شده توسط ChatGPT اگر چه طرحی برای کمک به درک روشهای مختلف پیادهسازی راهکارهای امنیتی نرمافزاری تلقی میشود اما همچنان با مدلی کارامد که برای اجرای حملات تهاجمی مهاجمان مناسب باشد، فاصله زیادی دارد.